Внешний вид

Упаковка

Судя по сайту производителя, карта поставляется в двух вариантах: без крепёжной планки и с однослотовой планкой. Продавец прикрутил двухслотовую планку, за что ему спасибо, но одного винта пожалел. Пришлось поправить дело синей изолентой.

А вот отломанное крепление системы охлаждения так просто не починить:

Впрочем, оставшиеся три крепления держат надёжно.

Технические характеристики

Идентичны обыкновенной GTX 1060 WINDFORCE 6G за исключением:

- отсутствуют видеовыходы

- используется шина PCI-E 1.0/1.1 (у игровых видеокарт — PCI-E 3.0)

- система охлаждения любой ценой старается удержать температуру графического процессора на отметке 55°

- видеоускоритель не определяется как игровой (отсутствует поддержка DirectCompute и PhysX)

Главные преимущества:

- EthHash (Ethereum, Ethereum Classic, Metaverse, Musicoin) – 25.1 MH/s;

- Cryptonightv7 (Monero) – 0.37 kH/s;

- Equihash (Zcash, Bitcoin Gold, Zclassic, HUSH) – 328 Sol/s;

- NeoScrypt (GoByte, VIVO, Trezarcoin) – 0.6 MH/s;

- Lyra2REv2 (Verge, Monacoin, Vertcoin) – 28.03 MH/s;

Стоит ли покупать ASUS MINING P106?

Поскольку ASUS Mining P106 разработана на базе графического процессора Nvidia GP106, теоретически производительность должна быть такая же, как и у GeForce GTX 1060. Однако на деле мы имеет совсем другие показатели.

Многие майнеры скептически относятся к P106, поскольку разница по производительности от той же GTX 1060 не существенная. В случае окупаемости, то она практически такая же как у GTX 1060 – 1.5 года. За свои $400 видеокарта P106 покажется отличным вариантом для майнинга, но учитывайте, что здесь нет дисплейных портов, поэтому если для Вас это не критично, то можно рассмотреть покупку.

Производитель обещает на 36 большую производительность в сравнении с игровыми аналогами, включая GeForce GTX 1060.

Системные требования

- наличие встроенного в процессоре видеоядра

- со слов продавца: не заработает на материнских платах H81/B85/Z87 (т. е. 4 поколения) производства ASUS, а также на более старых платах

- наличие слота PCI-E x16. Версия роли не играет, ведь карта в любом случае работает в режиме 1.1, а вот количество линий очень важно, ведь по шине не только происходит обмен данными с процессором, но и передаётся видеопоток. PCI-E 1.0 x16 по пропускной способности и без того эквивалентна всего лишь PCI-E 3.0 x4. Ещё большее снижение пропускной способности (например, если использовать слот x8) драматически скажется на производительности

(но есть обходные пути, о них позже)

Танцы с бубном

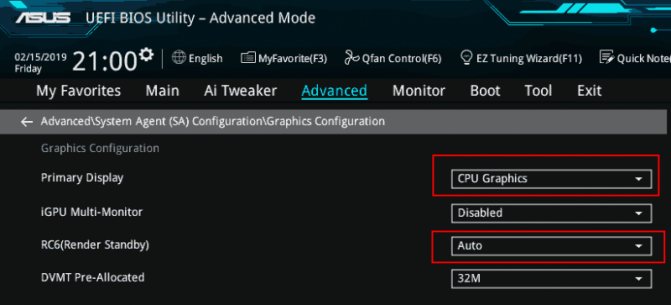

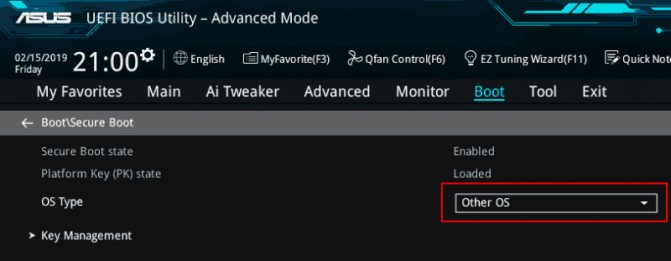

Вставляю карту, подключаю монитор к видеовыходу материнской платы, и… изображение отсутствует. Экспериментальным путём установлено, что требуется изменить пару настроек BIOS, выставив указанные на скриншоте значения:

Дальнейшие действия зависят от поколения процессора.

AMD APU (Ryzen G, Athlon GE, A10 и прочие), а также Intel поколения Haswell и новее

Windows 10

Начиная с Windows 10 1803, Microsoft реализовала подобие технологии Optimus, знакомой владельцам ноутбуков. Рендеринг в тяжёлых приложениях осуществляет дискретная видеокарта, а за вывод изображений и обработку 2D отвечает встроенное видеоядро процессора. Видеопоток передаётся по шине PCI-E, выводится через видеовыход материнской платы. Нужно установить графический драйвер на процессорное видеоядро. Обладатели Intel могут воспользоваться приложением Driver & Support Assistant, а для владельцев AMD предназначены драйверы Adrenalin.

Кроме того, придётся использовать драйвер NVIDIA не старше версии 417.22 (стабильная), либо 417.23 (бета). В более поздних то ли что-то изменилось, то ли NVIDIA реализовала защиту, но после установки модифицированного драйвера устройство либо будет висеть в диспетчере с ошибкой, либо (на конец 2022 года) просто откажется работать.

Во-первых, отключаем автоматическое обновления драйверов через Windows Update. В противном случае рано или поздно там появится более свежий драйвер, который будет автоматически установлен. В сети встречаются различные способы, но у меня сработал лишь один — через групповые политики. Для этого понадобится Windows 10 Professional или Enterprise.

Отключаем обновление драйверов для конкретного устройства

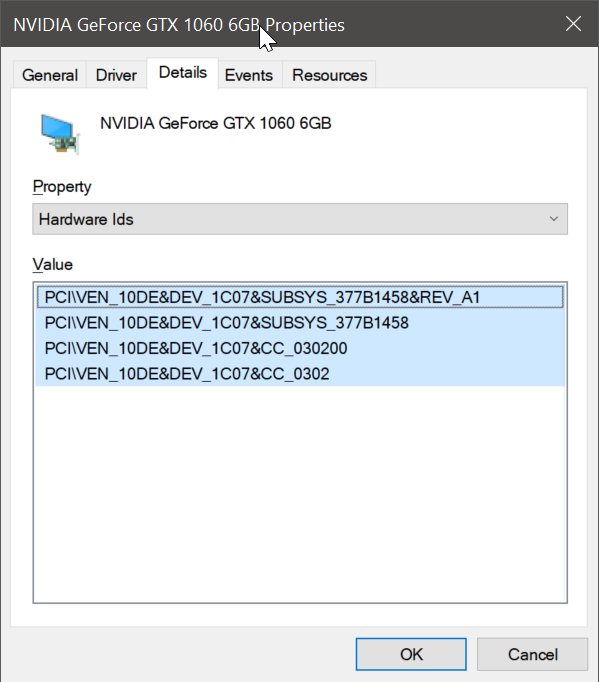

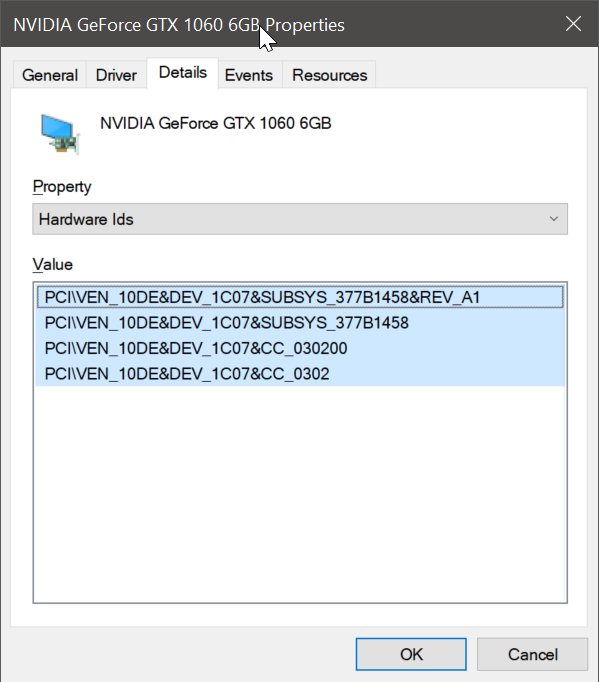

В свойствах видеоадаптера в диспетчере устройств смотрим его идентификаторы (4 штуки):

Пуск → Выполнить → gpedit.msc → Конфигурация компьютера → Административные шаблоны → Система → Установка устройства → Ограничение на установку устройств → Запретить установку устройств с указанными кодами устройств → Включено → Показать → Добавляем туда 4 строчки, которые смотрели выше.

Во-вторых, устанавливаем драйвер:

Если вам нужна поддержка PhysX (трудный путь)

Отключаем в BIOS безопасную загрузку (Secure Boot):

Скачиваем и распаковываем дистрибутив, правим файл /Display.Driver/nv_dispi.inf. Методика проста — нужно найти и удалить строки, содержащие NVIDIA_DEV.1C07

(1C07 — идентификатор P106-100). Затем в файл nvaci.inf добавить следующие строки: после

%NVIDIA_DEV.1BE1.1243.1025% = Section064, PCI\VEN_10DE&DEV_1BE1&SUBSYS_12431025 добавить (да, на конце пробел) %NVIDIA_DEV.1C07% = Section066, PCI\VEN_10DE&DEV_1C07

после (да, снова такая же строка)

%NVIDIA_DEV.1BE1.1243.1025% = Section064, PCI\VEN_10DE&DEV_1BE1&SUBSYS_12431025 добавить %NVIDIA_DEV.1C07% = Section066, PCI\VEN_10DE&DEV_1C07

после

%NVIDIA_DEV.1BE1.1243.1025% = Section063, PCI\VEN_10DE&DEV_1BE1&SUBSYS_12431025 добавить %NVIDIA_DEV.1C07% = Section065, PCI\VEN_10DE&DEV_1C07

после

NVIDIA_DEV.1BE1.1243.1025 = «NVIDIA GeForce GTX 1070» добавить NVIDIA_DEV.1C07 = «NVIDIA P106-100»

При желании можно поменять

NVIDIA_DEV.1C07 = «NVIDIA P106-100» на NVIDIA_DEV.1C07 = «NVIDIA GeForce GTX 1060 6GB» но это ни на что не влияет, кроме отображаемого имени в диспетчере задач. Приложения наподобие GeForce Experience всё равно опознают карту как P106-100.

Готовый драйвер (удалены все необязательные (и по большей части неактуальные для этой карты) компоненты типа телеметрии, поддержки вывода звука, ShadowPlay… оставлены лишь сам видеодрайвер и PhysX)

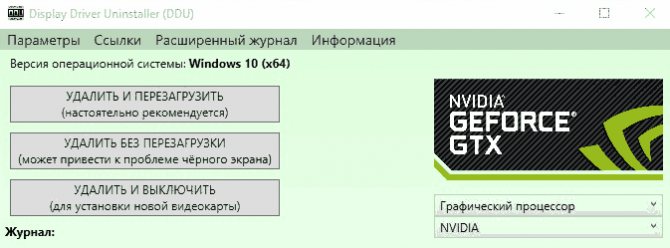

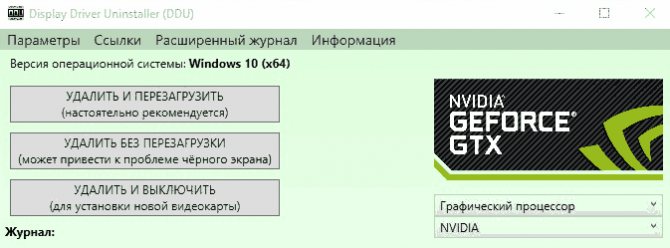

После этого, скачиваем Display Driver Uninstaller, отключаем сетевой адаптер (или вытаскиваем сетевой кабель). Открываем командную строку с правами администратора и выполняем:

bcdedit /set {current} testsigning on Перезагружаемся Запускаем DDU, чистим систему от драйверов NVIDIA:

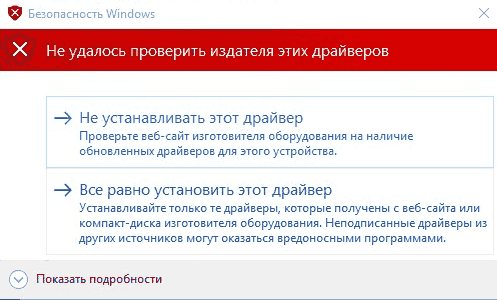

Заходим в диспетчер устройств и выполняем «Действие» → «Обновить конфигурацию оборудования». Необходимо добиться того, чтобы вместо дискретной видеокарты отображался «3D-видео контроллер»: Запускаем setup.exe и устанавливаем драйвер. Устанавливать GeForce Experience смысла нет, она всё равно «видит», что карта не игровая, функции типа ShadowPlay работать не будут. Выполняем чистую установку. Соглашаемся установить драйвер без проверки издателя:

После установки драйвера в диспетчере устройств не должно остаться устройств с восклицательными знаками.

Открываем командную строку с правами администратора и отключаем установку неподписанных драйверов (на неё очень нервно реагируют всякие античиты):

bcdedit /set {current} testsigning off Перезагружаемся в BIOS, включаем безопасную загрузку там же, где отключали. Загружаемся в Windows, включаем сетевой адаптер или втыкаем сетевой кабель.

Если вам не нужна поддержка PhysX (лёгкий путь)

Скачиваем дистрибутив и штатно устанавливаем. Устанавливать GeForce Experience смысла нет, она всё равно «видит», что карта не игровая, функции типа ShadowPlay работать не будут.

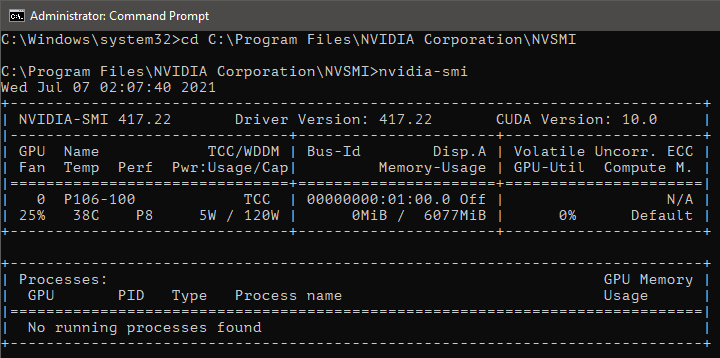

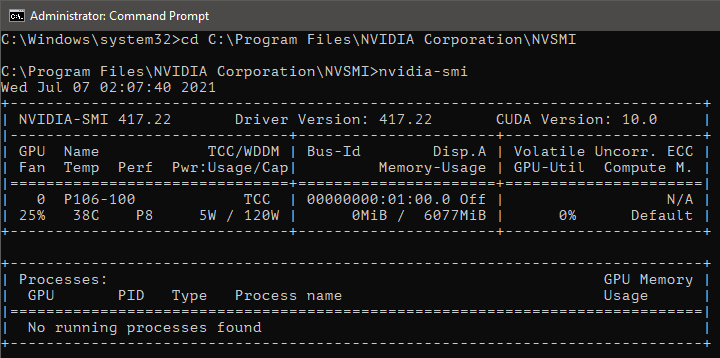

Драйвер установлен, теперь превратим карту в игровую. Видеокарты NVIDIA могут работать в одном из двух режимов: WDDM (Windows Display Driver Model) и TCC (Tesla Compute Cluster). Не-игровые карты (майнинговые и всякие там Tesla) по умолчанию работают именно в режиме TCC, поэтому с точки зрения ОС у них отсутствует поддержка Direct3D. Режим работы переключается утилитой nvidia-smi, поставляемой вместе с драйвером:

1) Запускаем командную строку от имени администратора и переходим в каталог с утилитой:

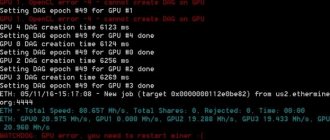

cd «C:\Program Files\NVIDIA Corporation\NVSMI» 2) Запускаем утилиту: nvidia-smi.exe 3) Видим примерно такой выхлоп:

из которого следует, что наша карта имеет идентификатор 0 и работает в режиме TCC.

4) Меняем режим работы:

nvidia-smi -g 0 -dm 0 где -g 0 — идентификатор карты, который мы видели выше, а -dm 0 включает режим WDDM, как описано в документации.

Не перезагружаясь, заходим в ветку реестра HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\Class\{4d36e968-e325-11ce-bfc1-08002be10318} и видим там подразделы (0000, 0001, …), соответствующие видеоадаптерам (встроенная процессорная графика и дискретная видеокарта). Переходим в подраздел, соответствующий нашей P106-100 и выставляем ключу EnableMsHybrid значение 1 (если такого ключа нет, создаём его — тип DWORD 32-бита; некоторые пользователи сообщают, что у них заработало только, когда выставили значение 2, имейте в виду). Этим изменением реестра мы заставим работать панель управления NVIDIA (в противном случае она откажется запускаться, ссылаясь на то, что к видеокарте не подключён монитор). Наконец-то перезагружаемся.

Если теперь запустить GPU-Z, то он сообщит, что у карты появилась поддержка DirectCompute (и PhysX, если вы проделали манипуляции для его активации и, разумеется, установили сам PhysX вместе с драйвером):

Заходим в панель управления NVIDIA, в разделе «Управление параметрами 3D → Предпочитаемый графический процессор» выбираем «Высокопроизводительный процессор», а в разделе «Установка конфигурации PhysX» выбираем P106-100 в качестве процессора PhysX.

Linux

Устанавливаем проприетарный видеодрайвер NVIDIA из репозиториев, а также Steam/Lutris/Wine. Всё работает «из коробки».

Windows 7

На форуме LTT предложили такое решение: To force vga output in Windows 7 you need to go to the «Screen resolution» menu, click on «Detect» button — another gray screen(s) should pop up in the menu. Click on one of them, and in the drop down menu select something like «Try to connect VGA display on P106-100» After that select «Extend Displays» and apply

Then if you set your «virtual monitor» as a Default (Don’t do this unless you have a program to switch windows between monitors with keys!!! I use Ultramon) program will start there and use the P106-100 GPU and you can use your hotkey to switch to your main monitor and it will be good»

Intel поколения Ivy Bridge и старее

Учтите, что поддержки DX12 у вас не будет

Windows 10

linustechtips.com/topic/1001580-p106-now-support-directx-not-official/page/10/?tab=comments#comment-13232905

Linux

Возможно, всё будет работать «из коробки» после установки проприетарного видеодрайвера NVIDIA из репозиториев. Пока никто не проверял.

Windows 7

На форуме LTT предложили такое решение, но пока никто не проверял его со старыми процессорами: To force vga output in Windows 7 you need to go to the «Screen resolution» menu, click on «Detect» button — another gray screen(s) should pop up in the menu. Click on one of them, and in the drop down menu select something like «Try to connect VGA display on P106-100» After that select «Extend Displays» and apply

Then if you set your «virtual monitor» as a Default (Don’t do this unless you have a program to switch windows between monitors with keys!!! I use Ultramon) program will start there and use the P106-100 GPU and you can use your hotkey to switch to your main monitor and it will be good»

Тестирование

Поскольку карта идентична по характеристикам обычной GTX 1060 6GB, то единственный вопрос, который интересует — падает ли производительность из-за низкой пропускной способности шины PCI-E 1.0.

Тесты проведены на платформе:

- Core i7-6700 ES @ 3.7 ГГц

- ASUS Z170-P

- 16 ГБ DDR4-2133 в одноканальном режиме

Unigine Valley Benchmark 1.0

Render: Direct3D11 Mode: 1920×1080 8xAA fullscreen Preset: Extreme HD FPS: 65.7 Score: 2748 Min FPS: 31.9 Max FPS: 125.8

Набранное количество баллов соответствует GTX 1060 6GB.

Unigine Heaven Benchmark 4.0

Render: Direct3D11 Mode: 1920×1080 8xAA fullscreen Quality: Ultra Tessellation: Extreme FPS: 61.7 Score: 1555 Min FPS: 25.5 Max FPS: 125.2

12.5% потеря производительности по сравнению с GTX 1060 6GB.

Final Fantasy XV Benchmark

9% и 7% падения производительности соответственно.

Возможно, с более производительным процессором и двухканальным режимом работы памяти было бы получше. Также стоит отметить, что технология Ansel работает, поскольку не привязана к GeForce Experience.

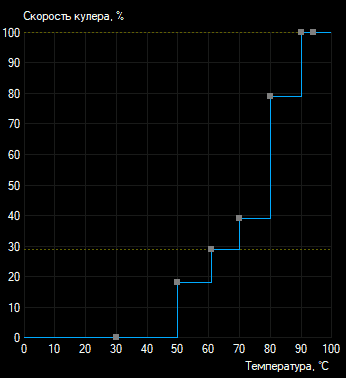

Под нагрузкой проявляется ещё одна особенность карты — она старается удержать температуру графического процессора на отметке 55°. Уровень шума при этом сложно назвать комфортным. Для майнеров это не критично, но мы-то геймеры… Проблема решается одним из двух способов:

способ 1 (на свой страх и риск)

— прошить BIOS от аналогичной карты, у которой температурные лимиты выставлены более расслабленно:

- находим на TechPowerUp подходящий BIOS. Чтобы увидеть прошивки для P106-100, нужно в графе «GPU Brand» выбрать «Unverified Uploads», а «Card Model» выбрать «P106-100»

- при выборе прошивки внимательно смотрите, чтобы совпадал объём памяти (6 ГБ) и чтобы в «Memory Support» поддерживался производитель памяти, распаянной на конретно вашей карте

- перебором удалось найти более старый BIOS. В нём прописаны вполне вменяемые скорости вращения вентиляторов

- BIOS прошивается с помощью NVFlash командами nvflash —protectoff nvflash 213313.rom —overridesub без ключа «—overridesub» утилита откажется прошивать, поскольку в старом биосе производителем указана Gigabyte, а в новом — NVIDIA

- при успехе перезагружаемся и повторяем манипуляции с установкой драйвера и правкой реестра

способ 2 (безопасный универсальный)

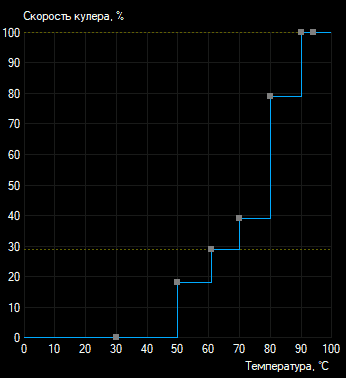

— указать желаемую кривую температур в MSI Afterburner:

Какой процессор выбрать для майнинга на видеокартах

При сборке фермы некоторые майнеры сильно экономят на процессоре, что приводит к загрузке CPU на 90-95% и просадке хешрейта всей фермы. Чтобы такого не случилось, нужно соблюдать несколько правил:

- Процессоры возрастом более 12 лет не справятся с сильной нагрузкой со стороны майнера и будут наблюдаться просадки.

- Не стоит обращать снимание на Celeron процессоры и одноядерные Pentium. Самый оптимальный вариант, если нужно сэкономить на ЦП — это Intel 775 socket серии. E8400 и ранние модели сейчас можно купить за бесценок на том же Aliexpress.

FAQ

Обязательно ли заказывать из Китая?

Поскольку, начиная с Pascal, NVIDIA в обязательном порядке требует наличие цифровой подписи у прошивок, «китайские» карты не имеют какой-то особой, модифицированной прошивки. Следовательно, ничем не отличаются от доступных у нас.

Говорят, что некоторые игры не работают при таком раскладе?

Я лично проверил такие игры как Ведьмак 2, Ведьмак 3, World of Warcraft, Nier: Automata, Metro Exodus, Hearthstone, Star Wars: Battlefront II. Всё работает. Не завёлся только бенчмарк 3DMark.

А если прошить BIOS от 1060 6GB?

Мне удалось пропатчить все проверки в утилите NVFlash, но программно прошить BIOS от другого чипа невозможно, потому что Device ID видеокарты и Device ID прошивки сверяется не только утилитой, но и самим видеочипом. Попытка прошить аппаратным программатором привела к BSOD. Более того, не помогает даже замена платы (т.е. пересадка видеочипа P106-100 на плату от 1060 со всей обвязкой и прошивкой). Таким образом:

- идентификатор карты намертво вшит в видеочип (изменить его по понятным причинам невозможно)

- чип отказывается работать при несовпадении идентификаторов чипа и прошивки (поэтому с прошивкой от 1060 он не заработает)

- изменить идентификатор в прошивке невозможно, начиная с Pascal, прошивки имеют цифровую подпись, при нарушении которой чип также отказывается работать (поэтому не получится взять прошивку от 1060 и перебить идентификатор, чтобы разблокировать все возможности 1060)

Вывод: превратить P106-100 в 1060 невозможно

.

Какие ещё есть карты для майнинга?

P106-090 — похожа на GTX 1050 Ti, имеет более широкую шину памяти, большие частоты, но всего 3 гигабайта памяти. P104-100 — разогнанная GTX 1070 с урезанным вдвое объёмом памяти. P104-101 — копия GTX 1080. P102-100 — урезанная версия GTX 1080 Ti с 5 ГБ памяти. P102-101 — то же самое, но уже с 10 ГБ памяти.

Нужно понимать, что чем мощнее карта, тем больше она будет упираться в шину. Обратите внимание, встречаются карты с шиной, урезанной до PCI-E 1.1 x4

! Например, P104-100 производства Gigabyte и P106-90 производства Zotac. Это очень бьёт по производительности.

На всякий случай, привожу идентификаторы этих карт (драйверы модифицируются аналогично):

- 1C09 = «NVIDIA P106-090»

- 1B87 = «NVIDIA P104-100»

- 1BC7 = «NVIDIA P104-101»

Можно ли поставить такую карту в SLI с игровой?

Да, см. тут и тут. Причём необязательно с GTX 1060. Например, можно поставить GP106-100 в пару с GTX 1070.

Можно ли для вывода изображения использовать дешёвую дискретную видеокарту вместо интегрированного видео?

Единственный вариант использования двух дискретных видеокарт — SLI, описан выше.

Как собрать майнинг ферму из видеокарт

Собрать ферму из видеокарт несложно. Но человеку, который далек от компьютеров, это сделать проблематично. Просто потому, что большинство даже не знает, как устроен их ПК, не говоря уже о чем-то более сложном. Поэтому обучающее видео будет как нельзя кстати. Из этого видео вы можете узнать, какова окупаемость у фермы, как её собрать и как запустить.

Как и везде, есть пара «но»:

- Разгон видеокарты очень сильно влияет на температуру вашей установки. Поэтому лучше запастись охлаждением.

- Установка прошивкиБиоса – довольно сложная штука, поэтому лучше сделать пару бэкапов системы.

В общем-то, это все сложности, с которыми вы можете столкнуться. Помните, что настройка каждой видеокарты и последующее наблюдение за их состоянием тоже входит в обязанности майнера.

Как сделать свою ферму дома, мы разобрались. Теперь о том, какие криптовалюты стоит майнить.