17.02.2021

5 514

0

Можно часами говорить о важности выбора блока питания для сборки ПК, особенно, если целевая сборка предусматривает высокую производительность. Для подавляющего большинства каждодневных процессов более чем достаточно 500W-ого блока питания, но увеличение «аппетитов» нового игрового железа вынуждает обратить внимание на БП мощностью в 600-700W.

Ниже мы подобрали для Вас 12 блоков питания мощностью в 600-650W в ценовом диапазоне от 2500 до 14.000 рублей, которые прошли проверку временем, тестами и тысячами покупателей.

Примечание: Ни можем не сказать о том, что, даже если Вы столкнулись с браком с одним из 12 нижеприведённых блоков питания – это обстоятельство ещё не говорит о общем качестве БП указанной модели. Что за 2000, что за 22000 рублей остаётся вероятность скорого выхода из строя, и в ряде случаев виноват далеко не БП и производитель. Не забывайте о необходимости оставления запаса мощности, и о заботе о правильном выключении ПК и контроле электроэнергии.

Далее будут использоваться аббревиатуры технологий защиты БП от различных сценариев нагрузок:

- OVP (защита от превышения напряжения)

- OPP (защита от превышения мощности)

- OTP (защита от перегрева)

- UVP (защита от понижения напряжения в сети)

- SIP (защита от всплесков и бросков напряжения)

- SCP (защита от короткого замыкания).

Железный сайт

Страница 1 из 16

Введение

Больше года назад появились первые сведения об архитектуре NVIDIA под кодовым названием «GF 100» на конференции GTC. Тогда говорилось о непревзойденной мощности, которую предлагает данное графическое ядро с его 512 ядрами CUDA, 16 мультипроцессорами (SM). Плюс к этому 1.5 Гб памяти GDDR5. Все поклонники продукции данной компании ожидали от нее невероятной производительности в играх.

Но триумфа данной платы не состоялось. Триумфально вышли на рынок продукты компании AMD серии HD 5xxx. Во-первых, видеокарты ATI с поддержкой DirectX 11 были выпущены гораздо раньше и заполнили все сегменты рынка. Во-вторых, NVIDIA выпустили старшую видеокарту GTX 480 с 15 мультипроцессорами (SM) 480 ядрами CUDA в четырех кластерах GPC, а не c 512, как заявляли ранее. Видеокарта GTX 480 действительно имеет внушительную производительность, но проблема состоит в том, что энергопотребление и нагрев не укладываются ни в какие разумные рамки.

Сегодня у нас в гостях видеокарта, основанная на последней версии графического ядра NVIDIA, получившего название GF 110. Данный GPU отличается от GF 100 меньшим числом транзисторов на единицу площади кристалла, а также предлагает обещанные ранее 512 ядер CUDA и 16 мультипроцессоров SM. В NVIDIA также говорят об улучшении ситуации с энергопотреблением и нагревом чипа по сравнению с предшественником. Сегодня мы узнаем так, это или нет.

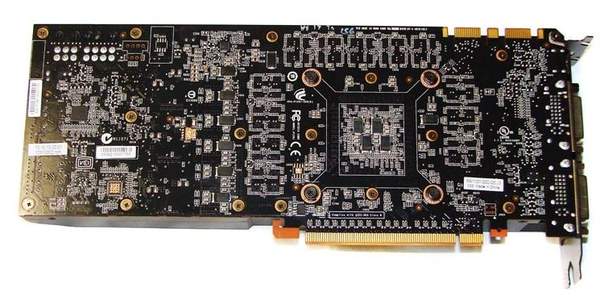

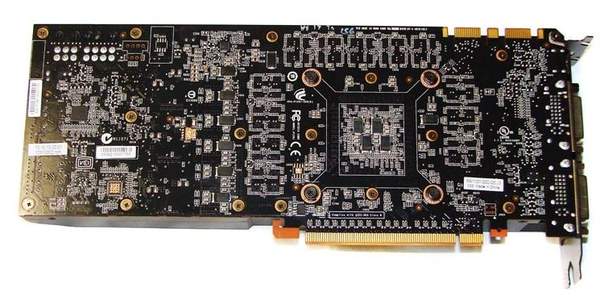

Осмотр видеокарты

Видеокарта попала на тестирование без упаковки. Поэтому мы не можем сообщить о комплектации видеокарты, и приводим изображения непосредственно GTX 580. Длина GTX 580 составляет 26 см, что точно соответствует GTX 480. За кожухом нельзя увидеть конструкцию радиатора, но она должна быть серьезной, так как система охлаждения должна отводить тепло от ядра с тремя миллиардами транзисторов.

Первые предложения GTX 580 от партнеров компании вряд ли будут различаться чем-то, кроме наклеек на кожухе. Для приведения энергопотребления и температуры ядра в разумные нормы NVIDIA пересмотрели архитектуру ядра в сторону уменьшения числа транзисторов на единицу площади кристалла. В чипе GTX 580 мы имеем 512 ядер CUDA и увеличенные тактовые частоты, по сравнению с GTX 480. Видеокарта предназначена для работы в слоте PCIe 16х.

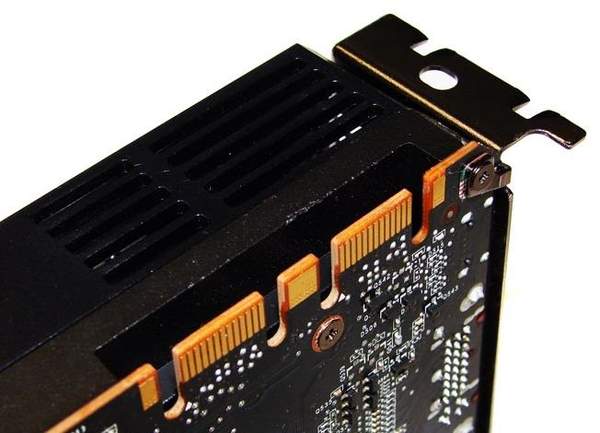

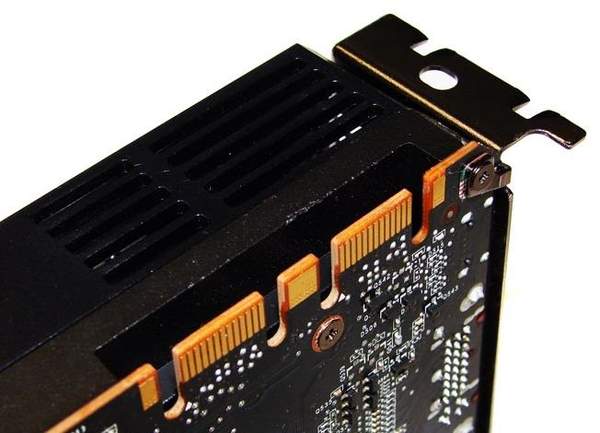

Видеокарта имеет два порта Dual link DVI и одного mini HDMI. Последний поддерживает передачу Dolby True HD и DTS HD Master Audio по HDMI. Не забудьте при этом установить драйвера Forceware версии 260 или более поздней. В заднем торце платы в кожухе имеются вентиляционные отверстия для подсоса более холодного воздуха из корпуса. Данная конструктивная особенность может оказаться полезной при установке двух или более видеокарт в SLI (когда подсос воздуха турбиной ограничен).

На плате NVIDIA GTX 580 предусмотрены два разъема для подключения дополнительного питания: 6-ти и 8-ми контактный. Рекомендуемый блок питания для системы с видеокартой GTX 580 должен иметь номинал 600 ватт. Видеокарта GTX 580 имеет TDP 244 ватт, что на 56 ватт меньше, чем для GTX 480. GTX 580 поддерживает объединение в массивы из двух и трех видеокарт (SLI и Tri-SLI). В верхней части PCB Вы можете видеть два интерфейса для организации массива видеокарт. Рядом с ними в кожухе можно увидеть небольшой гриль для вывода нагретого воздуха.

Объединив две такие видеокарты в SLI, Вы сможете собрать на их базе NVIDIA Surround или 3D Vision системы. Суммарное разрешение трех мониторов в данном случае будет до 7680 x 1600.

Один из главных недостатков чипа GTX 480 заключается в его огромном тепловыделении. Чтобы отводить все это тепло чипа, на референсной системе охлаждения неизбежно приходилось увеличивать обороты вентилятора, что приводило к повышению уровня шума. NVIDIA не могли оставить данный факт без внимания, и для GTX 580 разработали более эффективную систему охлаждения. Система охлаждения на GTX 580 по конструкции отличается от кулера на тепловых трубках, используемого на GTX 480. Инженеры решили проблему отвода тепла на GTX 580 установкой радиатора, имеющего конструкцию с использованием «Vapor Chamber» (данное решение довольно часто встречается на видеокартах Sapphire). Принцип работы испарительной камеры (Vapor Chamber) похож на тот, что используется в тепловым трубках, но является более эффективным решением. От силовых транзисторов тепло отводится при помощи алюминиевой пластины, которая одновременно является каркасом кулера. По изображениям ниже Вы можете получить представление о том, как работает система охлаждения NVIDIA GTX 580.

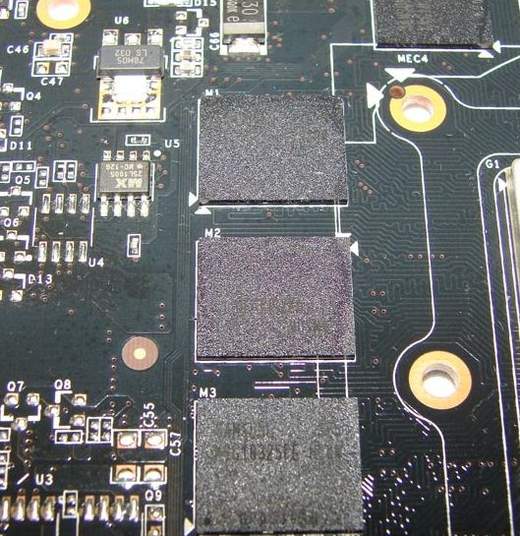

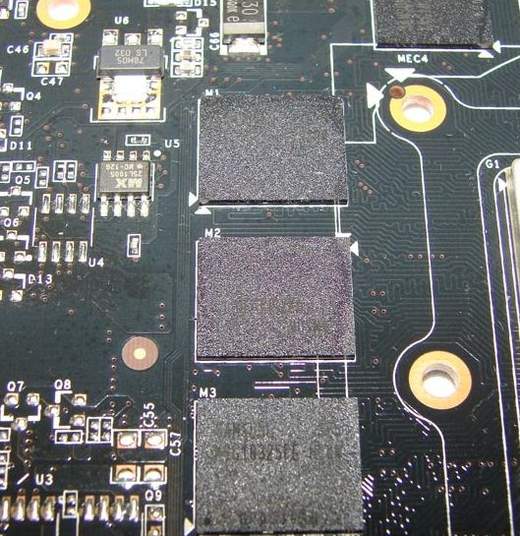

Наконец, не менее важный факт это то, что ядро GF 110 — это полноценная версия архитектуры Fermi, которую мы ожидали с момента ее первого анонса. GF 110 имеет четыре вычислительных кластера GPC, 16 мультипроцессоров SM, 512 ядер CUDA, 16 блоков Polymorph engine, 64 текстурных модуля, 48 модулей ROP. По сравнению с GTX 480 увеличены тактовые частоты: до 772 МГц (ядро) и 1544 МГц (шейдерный блок). Видеокарта GTX 580 оснащена 1536 Мб памяти GDDR5, имеющей шину 384 бит. Память работает на частоте 2004 МГц. 12 микросхем памяти, установленные на NVIDIA GTX 580, произведены Samsung.

Видеокарта GTX 580 предназначена для требовательных энтузиастов и геймеров. Посмотрим на спецификации данного монстра.

Предыдущая — Следующая >>

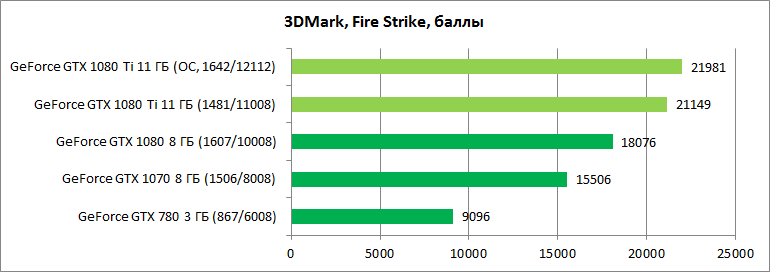

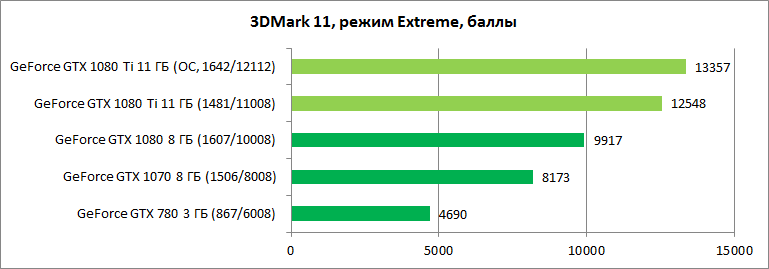

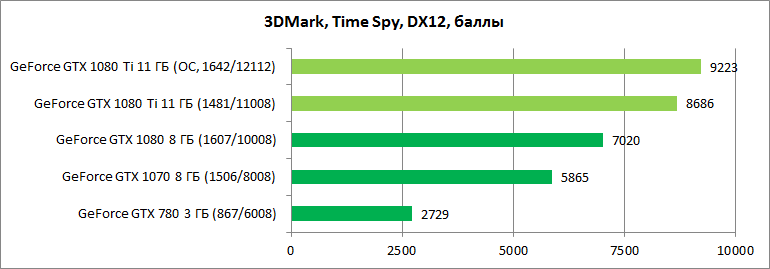

Производительность

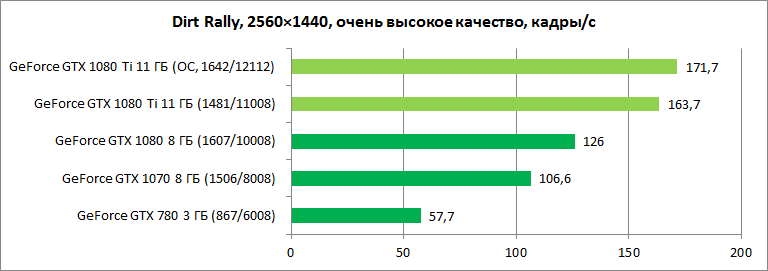

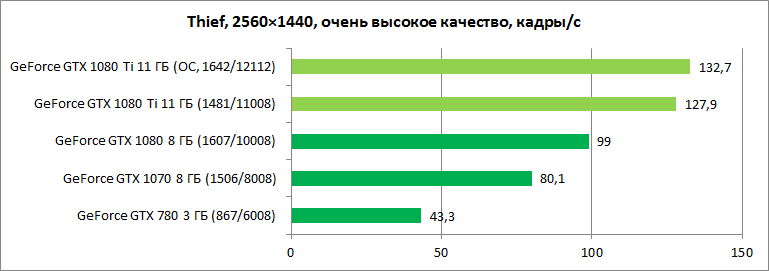

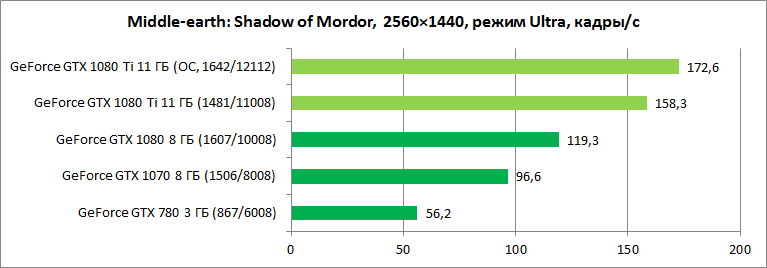

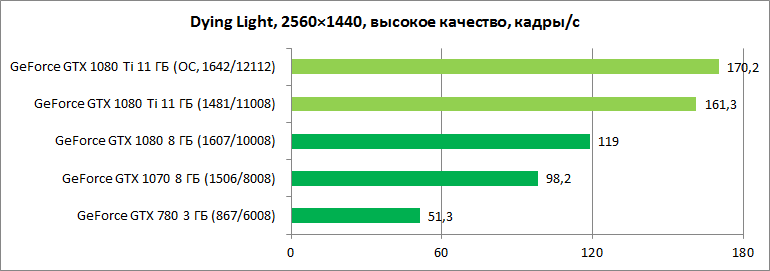

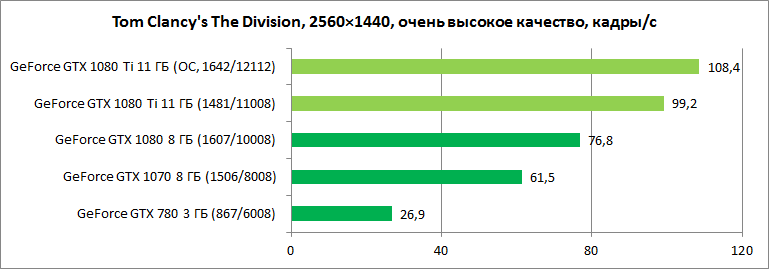

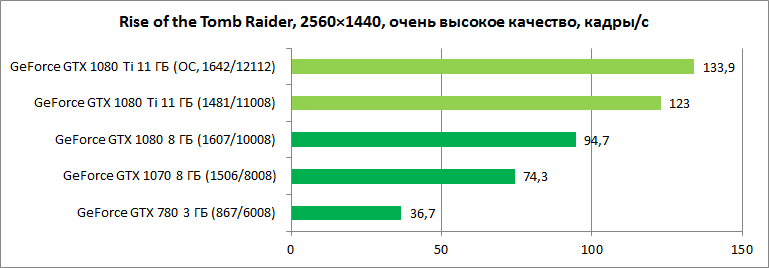

Для оценки производительности GeForce GTX 1080 Ti мы использовали показатели нескольких видеокарт. GeForce GTX 1080 позволит ощутить преимущество “титановой” версии над базовой видеокартой серии, оснащенной более простым графическим процессором. GeForce GTX 1070 включена в перечень участников, чтобы оценить показатели GeForce GTX 1080 Ti в сравнении с популярной сбалансированной моделью, пользующейся широкой популярностью. Кроме того, мы также добавили результаты GeForce GTX 780. Данная модель была представлена почти 4 года назад и стоила почти столько же ($649), как и участница нашего обзора. Интересно посмотреть, как же ситуация изменилась за прошедшее время.

В перечне участников теста, к сожалению, не оказалось видеокарт с чипами AMD. Radeon RX 480/580 – устройства среднего класса, которые на фоне одночиповых флагманов смотрелись бы очень неубедительно. Возможно академический интерес представляло бы сравнение показателей с таковыми для Radeon RX Fury/Fury X, но этих возрастных адаптеров уже фактически нет на рынке, да и практическая полезность здесь сомнительна. Очень ждем Radeon RX Vega, с выходом которых в топ-сегменте должна появиться интрига. Пока же на вершине графической иерархии устройства от NVIDIA томятся в гордом одиночестве. Посмотрим на текущую расстановку сил.

Во время тестирований мы использовали экран с разрешением 2560×1440, устанавливая для игр пресеты с максимальным качеством графики или близким к таковому. Как показывают замеры, в таких условиях GeForce GTX 1080 Ti примерно на треть опережает GeForce GTX 1080. Причем чуть более скромные общие результаты в синтетических тестах можно объяснить тем, что на общий показатель также влияет производительность процессора, который был неизменен.

В реальных играх можно было наблюдать прирост на уровне 27–35%. При этом здесь также стоит учесть нюанс, заключающийся в том, что для воссоздания стоковых GTX 1070/1080 мы использовали адаптеры MSI серии GAMING с оригинальными системами охлаждения, снизив базовые значения частот GPU до рекомендуемых значений. Однако более агрессивный алгоритм GPU Boost все же обеспечивал этим моделям небольшое преимущество над референсными GTX 1070/1080. Потому, при сравнении со стоковыми моделями разница будет еще чуть больше. Преимущество GTX 1080 Ti наверняка будет более весомым и при повышении разрешения экрана.

Преимущество над GeForce GTX 1070 составляет в среднем весомые 50–65%. В целом ряде игр GeForce GTX 1080 Ti может обеспечить порядка 150 кадров/c при максимальных настройках качества графики и разрешении 1440p. Это повод владельцу такой видеокарты смотреть в сторону моделей мониторов с частотой обновления экрана 144 Гц. Здесь возможности таких игровых моделей будут реально востребованы. Подобные показатели также позволяют рассчитывать на комфортную производительность при разрешении 4К.

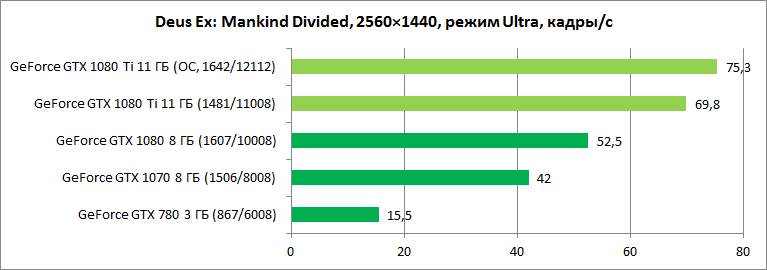

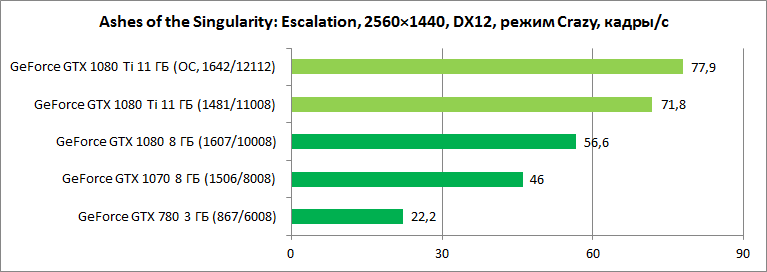

Однако в некоторых особо тяжелых проектах лишь GeForce GTX 1080 Ti обеспечивает достаточное количество кадров/c даже в 2560×1440. Например, теперь наконец-то появилась видеокарта, позволяющая использовать в таком режиме пресет качества графики «Запредельное» в игре The Witcher 3: Wild Hunt и не наблюдать неприятные просадки производительности. Оказалось, что уже существует графический адаптер, способный справиться грубой силой с особенностями движка Deus Ex: Mankind Divided, обеспечивая порядка 70 кадров/c в режиме Ultra. Как видим, GTX 1080 дает здесь лишь средние 52 кадра/c, а это значит, что на сложных сценах количество кадров/c будет снижаться до некомфортных значений.

Tom Clancy’s Ghost Recon Wildlands также очень требовательна к ресурсам видеокарты. Режим настроек качества Ultra могут себе позволить либо любители эффектных скриншотов, либо владельцы топовых видеокарт. Средние 60 кадров/c на GeForce GTX 1080 Ti – это настоящая боль для тех, кто располагает менее скоростной видеокартой.

Ashes of the Singularity: Escalation в режиме Crazy также способна серьезно озадачить даже GTX 1080 Ti, но если последняя все же справляется с такой нагрузкой, то обычной GTX 1080 уже не хватает для максимального комфорта. В таких случаях придется снижать качество графики.

Дополнительный разгон может быть полезен даже GeForce GTX 1080 Ti. После повышения тактовых частот графического процессора и микросхем памяти производительность видеокарты увеличилась примерно на 6–9%. Прирост сравнительно невелик. Даже в штатном режиме GPU значительно ускоряется, потому дельта фактических частот после GPU Boost ниже разницы условных базовых значений. В связи с этим интересно было бы оценить эффективность разгона альтернативных вариантов GeForce GTX 1080 Ti.

Представленные на диаграммах результаты видеокарты GeForce GTX 780 3 ГБ – прекрасная возможность оценить прогресс в области дискретной графики. Всего 4 года назад это было топовое решение стоимостью $650+. В среднем GeForce GTX 1080 Ti оказывается в 3-4 раза производительнее возрастной видеокарты с архитектурой Kepler. Да, используемые режимы абсолютно некомфортны для GeForce GTX 780. Она имеет всего 3 ГБ памяти на борту, потому часть текстур приходится держать в системной ОЗУ. Базовая частота GPU в 863 МГц смешна по нынешним меркам, а ограниченная поддержка DX12 и отсутствие дополнительных оптимизаций в драйверах не позволяют раскрыть возможности данной модели. Но такова жестокая реальность с которой приходится сталкиваться владельцам подобных устройств. Конечно, можно снизить качество графики и уменьшить разрешение, получив более комфортные условия игры, но в идентичных «тяжелых» режимах между устройствами различных поколений настоящая пропасть.

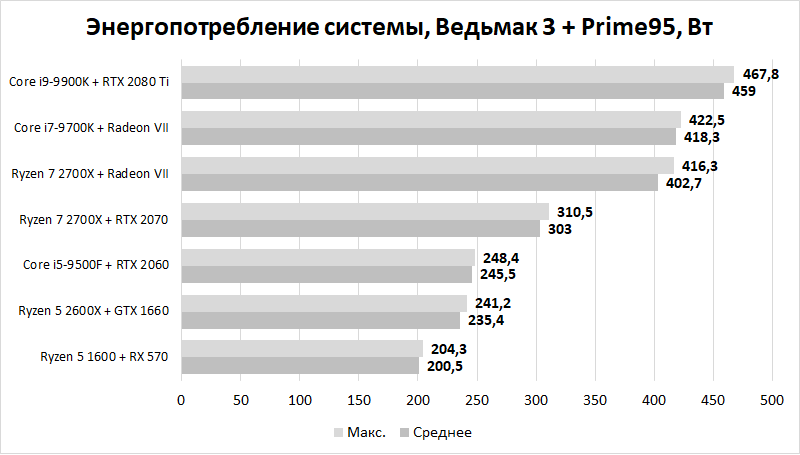

⇡#Какая мощность необходима современным игровым ПК

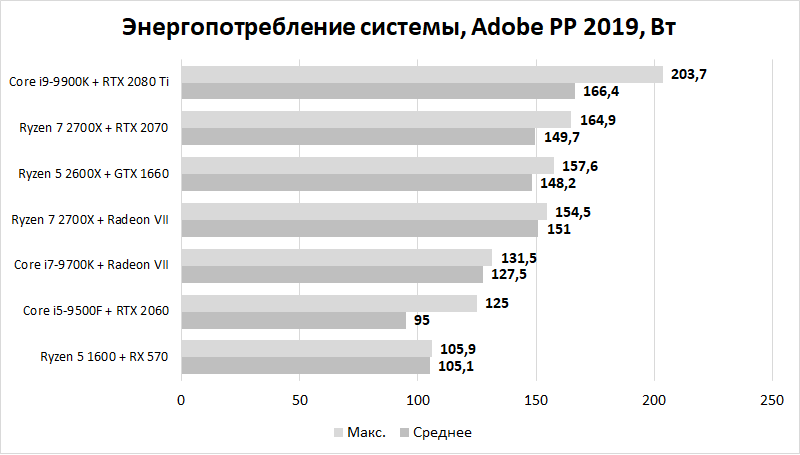

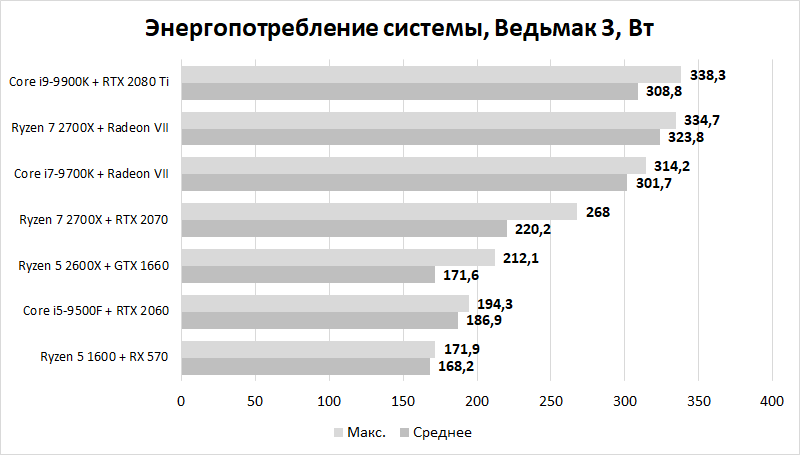

Еще раз отмечу: эта статья в определенной степени привязана к рубрике «Компьютер месяца». Поэтому если вы заскочили к нам на огонек впервые, то я рекомендую ознакомиться хотя бы с августовским выпуском. В каждом «Компьютере месяца» рассматриваются шесть сборок — преимущественно игровых. Похожие системы я использовал и для этой статьи. Давайте знакомиться:

- Связка Ryzen 5 1600 + Radeon RX 570 + 16 Гбайт ОЗУ — это аналог стартовой сборки (35 000-37 000 рублей за системный блок без учета стоимости ПО).

- Связка Ryzen 5 2600X + GeForce GTX 1660 + 16 Гбайт ОЗУ — это аналог базовой сборки (50 000-55 000 рублей).

- Связка Core i5-9500F + GeForce RTX 2060 + 16 Гбайт ОЗУ — это аналог оптимальной сборки (70 000-75 000 рублей).

- Связка Core i5-9600K + GeForce RTX 2060 + 16 Гбайт ОЗУ — еще один вариант оптимальной сборки.

- Связка Ryzen 7 2700X + GeForce RTX 2070 + 16 Гбайт ОЗУ — это аналог продвинутой сборки (100 000 рублей).

- Связка Ryzen 7 2700X + Radeon VII + 32 Гбайт ОЗУ — это аналог максимальной сборки (130 000-140 000 рублей).

- Связка Core i7-9700K + Radeon VII + 32 Гбайт ОЗУ — еще один вариант максимальной сборки.

- Связка Core i9-9900K + GeForce RTX 2080 Ti + 32 Гбайт ОЗУ — это аналог экстремальной сборки (220 000-235 000 рублей).

К сожалению, достать процессоры Ryzen 3000 на момент проведения всех тестов мне не удалось, но полученные результаты от этого не станут менее полезными. Тот же Ryzen 9 3900X, если судить по нашему обзору, потребляет меньше Core i9-9900K — получается, в рамках экстремальной сборки изучить энергопотребление 8-ядерника Intel будет даже интереснее и важнее.

А еще, как вы могли заметить, в статье используются только массовые платформы, а именно AMD AM4 и Intel LGA1151-v2. Я не стал задействовать HEDT-системы, такие как TR4 и LGA2066. Во-первых, мы уже давно отказались от них в «Компьютере месяца». Во-вторых, с появлением в массовом сегменте 12-ядерного Ryzen 9 3900X и в преддверии скорого выхода 16-ядерного Ryzen 9 3950X такие системы стали уж больно узкоспециализированными. В-третьих, потому, что обзор, например, модели Core i9-9900X показывает, что Core i9-9900K все равно дает всем прикурить в плане энергопотребления, в очередной раз доказывая, что заявленная производителем расчетная тепловая мощность мало о чем говорит потребителю.

А теперь перейдем к результатам тестирования.

Если честно, результаты тестирования в таких программах, как Prime95 и Adobe Premier Pro 2022, я привожу больше для ознакомления — для тех, кто не играет и не пользуется дискретными видеокартами. Можете смело ориентироваться на эти данные. В основном же здесь нас интересует поведение тестовых систем в нагрузках, приближенных к максимальным.

А здесь наблюдаются весьма занятные вещи. В целом мы видим, что все рассмотренные системы потребляют не очень много энергии. Самой прожорливой, что вполне логично, стала система с Core i9-9900K и GeForce RTX 2080 Ti, но даже она в стоке (читай — без разгона) потребляет 338 Вт, если речь идет об играх, и 468 Вт — при максимальной нагрузке ПК. Получается, такой системе хватит блока питания на честные 500 Вт. Ведь так?

Обзор GTX 580

Внешне видеокарта выглядит очень стильно и компактно, в духе предыдущих плат от Nvidia. Лицевая сторона GTX 580 почти полностью перекрывается деталями системы охлаждения. С тыльной стороны платы находятся 2 разъема на 6- и 8-pin для подключения дополнительного питания.

Энергопотребление GTX 580 напрямую зависит от степени загрузки видеокарты. Максимально заявленный объем – 244 Ватт, однако после осуществления разгона количество потребляемой энергии может увеличиться до 250 Ватт.

Система охлаждения состоит из массивного медного радиатора и пластикового кулера, закрепленного с помощью большой крышки с защелками. Радиатор обходится без теплоотводных трубок, однако в основании теплосъемника установлена испарительная камера.

В целом, видеокарта вполне пригодна для использования, однако доводить ее возможности до точки экстремума в современных играх не стоит. Большинство игровых новинок GTX 580 обуздать не способна, а вот игры до 2012-2013 года работают на высоких настройках с приемлемой кадровой частотой.

Технические характеристики

Полная совместимость с библиотекой DirectX 11 позволяет графическому процессору поддерживать стабильно высокую частоту кадров, а также обеспечивает настоящий игровой реализм и детальную проработку окружения. Мощная видеокарта на ядре Nvidia GF110 имеет достаточно высокие показатели частот графического ядра и видеопамяти, что позволяет ей демонстрировать удовлетворительный результат в игровых тестированиях.

Характеристики GTX 580:

- Транзисторы – 3000 млн.;

- Тех.процесс – 40 нанометров;

- Количество CUDA-ядер – 512;

- Блоков текстур – 64;

- Количество рендеринг-блоков – 48;

- Частота графического ядра – 772 МГц;

- Шина памяти – 384 бит;

- Тип видеопамяти – GDDR5;

- Частоты видеопамяти – 4008 МГц;

- Объем памяти – 1546 МБ;

- Интерфейс – PCI-E 2.0;

- Последняя совместимая версия DirectX – 11;

- Энергопотребление – 244 Вт.

Если учесть, сколько стоит видеокарта GTX 580, то такие показатели можно считать весьма неплохими. Обновленный графический ускоритель основан на технологии GF100.

На первый взгляд, может показаться, что его усовершенствованная версия GF110 ничем не отличается от своего предшественника. Однако благодаря тому, что в GTX 580 активированы все мультипроцессоры, видеокарта способна задействовать все 512 CUDA-ядер, что существенно влияет на ее производительность в условиях максимальной нагрузки.

Цена GTX 580, вышедшей еще в 2010 году видеокарты, редко превышает отметку в 70 долларов, что свидетельствует о бюджетности и доступности устройства.

Конфигурация тестового стенда

| Процессор | Core ,5 ГГц | Intel, www.intel.ua |

| Кулер | Thermalright Archon Rev.A | Thermalright, www.thermalright.com |

| Материнская плата | ASUS PRIME Z270-A (Intel Z270) | ASUS, www.asus.ua |

| Видеокарта | MSI GeForce GTX 1080 GAMING X 8G, MSI GeForce GTX 1070 GAMING X 8G | MSI, ua.msi.com |

| Накопитель | HyperX Savage 960 ГБ (SHSS37A/960G)/Kingston KC300 120 ГБ (SKC300S37A/120G) | HyperX, www.hyperxgaming.com |

| Блок питания | Thermaltake Toughpower Grand TPG-1200M (1200 Вт) | Thermaltake, www.thermaltakeusa.com |

| Монитор | ASUS PB278Q (27″, 2560×1440) | ASUS, www.asus.ua |

⇡#Замечания о работе ускорителя в режиме максимальной загрузки при помощи стресс-тестов

Как мы писали выше, новые драйверы NVIDIA (262.99 и старше) определяют запуск утилит стресс тестирования (OCCT, FurMark 1.8) и занижают рабочие частоты ускорителя на 50%. При этом диагностическое ПО сторонних разработчиков пока не в состоянии корректно отследить такое снижение. В нашем случае, после запуска FurMark 1.8.5 были получены весьма сомнительные результаты, поэтому в этот раз мы решили не использовать стресс-тестирование для оценки температуры и энергопотребления, ограничившись лишь игровым режимом в Far Cry 2.

Как разогнать видеокарту Nvidia Geforce GTX 1080 Ti для майнинга

Поскольку GTX 1080 Ti является самой производительной видеокартой в потребительской линейке Nvidia, она заслужила наибольшую популярность среди майнеров. Видеокарта GTX 1080 Ti подходит для майнинга как нельзя лучше – благодаря отличному разгоночному потенциалу ее доходность на 30% выше, нежели в предыдущей модели из линейки. Для разгона видеоадаптера рекомендуется использовать утилиту MSI Afterburner. Чтобы разогнать видеокарту нужно выполнить следующие действия:

- Подвинуть ползунки частоты памяти и частоты ядра вправо на несколько МГц и сохранить изменения.

- Если видеоадаптер не сбрасывает настроек, подвиньте ползунки еще.

- Если настройки сбрасываются, снизьте немного частоту параметров.

Самый популярный вопрос среди людей, решивших заняться майнингом, звучит так: «Сколько мегахешей выдает видеокарта GTX 1080 Ti на эфире?». На алгоритме Dagger-Hashimoto не разогнанная видеокарта выдает приблизительно 32 Mh/s. При разгоне хешрейт можно увеличить до 37-38 Mh/s.

Игровые тесты

Перейдем к игровым приложениям и остановимся на методике тестирования. Измерение FPS проводилось с помощью утилиты FRAPS. Все игры были протестированы в трех наиболее актуальных разрешениях: 1920х1080, 2560х1440 и 3840х2160. Вручную отключены следующие параметры:

- VSync (вертикальная синхронизация)

Все остальные настройки, включая сглаживание, были установлены на максимально возможные. Для наглядности каждая игра снабжена видео с демонстрацией текущего значения FPS, частоты ядра и памяти, скоростью вращения вентилятора, а также отображением температуры под нагрузкой. Видеоматериал записан с помощью ShadowPlay при разрешении 3840х2160. Для просмотра рекомендуется использовать браузер Google Chrome.

Assassins Creed Syndicate

Batman Arkham Knight

Bombshell

Call Of Duty: Black Ops 3

Crysis 3

Dark Sould III

DiRT Rally

DOOM

Dying Light

Fallout 4

FarCry 4

GTA 4

METRO: Last Light

The Witcher 3

World Of Tanks

Если сопоставить все таблицы, то становится понятно, что GTX 1080 все-таки недостаточно для уверенной игры в 4К на максимальных настройках. Недостаток FPS в таком разрешении особенно заметен на примере таких игр, как: Assassin’s Creed Syndicate, Crysis 3 и Metro Last Light. Несмотря на это, при отключении или снижении такого параметра как сглаживание, у вас получится добиться приемлемого уровня производительности и для многих это станет приемлемым выходом из ситуации. Оптимальна GTX 1080 в первую очередь для игры на мониторах с разрешением 2560×1440, здесь можно не церемониться и выкручивать все настройки в играх на максимально возможные.

Сравнения разных производителей

Ниже представлено сравнение видеокарт, где можно изучить основные характеристики и узнать, сколько стоит GTX 1080 Ti в рублях от разных производителей.

| Параметр | Asus Strix | Msi Gaming X | Aorus Xtreme Edition 11G | Inno3D Ichill X4 | Palit | Evga | Zotac Mini |

| Частота памяти, МГц | 11114 | 11265 | 11448 | 11400 | 11010 | 11010 | 11400 |

| Частота ядра, МГц | 1594 | 1659 | 1746 | 1582 | 1709 | 1557 | 1506 |

| Пропускная способность, Гб/с | 488.6 | 489.4 | 498.6 | 501.6 | 484 | 484 | 484 |

| Цена, руб | 59000 | 72000 | 73000 | 67000 | 68000 | 67000 | 63000 |

Цены на Nvidia Geforce GTX 1080 Ti от разных производителей немного отличаются. Если вы хотите насладиться максимальной производительностью и не имеете ограничений в бюджете, лучшим вариантом будет покупка видеоадаптера от Aorus.

Графический TOP от NVIDIA

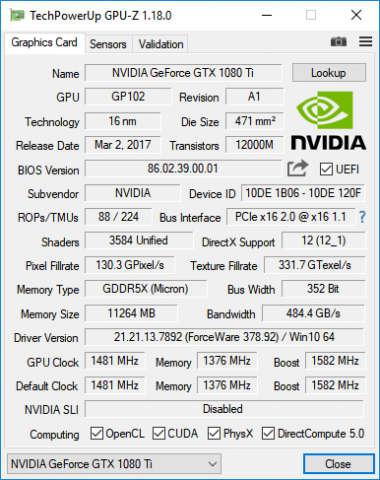

Для GeForce GTX 1080 Ti используется графический процессор GP102. Это тот же кристалл, что применяется и для GeForce TITAN X, но с минимальными упрощениями. Производитель сохранил количество вычислительных CUDA-блоков – 3584, и даже число текстурных модулей осталось неизменным – 224, а вот количество блоков растеризации уменьшено с 96 до 88.

Для новой видеокарты используется нестандартная разрядность шины памяти – 352 бита, вместо 384 бит у TITAN X, а объем локальной ОЗУ уменьшен с 12 ГБ до 11 ГБ, но при этом GDDR5X работает на 11 008 МГц вместо 10 008 МГц. Однако, учитывая возросшие частоты как графического процессора, так и микросхем памяти, еще до практических тестов становилось понятно, что в плане производительности GeForce GTX 1080 Ti как минимум не будет уступать более именитой модели. А если еще учесть почти двукратную разницу в рекомендованной цене видеокарт, то было очевидно, что непродолжительный жизненный цикл GeForce TITAN X подходит к своему завершению.

| GeForce TITAN Xp | GeForce GTX 1080 Ti | GeForce TITAN X | GeForce GTX 1080 | |

| Наименование кристалла | GP102 | GP102 | GP102 | GP104 |

| Техпроцесс производства, нм | 16 | 16 | 16 | 16 |

| Площадь кристалла, мм² | 471 | 471 | 471 | 314 |

| Количество транзисторов, млрд | 12 | 12 | 12 | 7,2 |

| Тактовая частота GPU, МГц | 1480/1582 | 1480/1582 | 1417/1531 | 1607/1733 |

| Количество потоковых процессоров | 3840 | 3584 | 3584 | 2560 |

| Количество текстурных блоков | 240 | 224 | 224 | 160 |

| Количество блоков растеризации | 96 | 88 | 96 | 64 |

| Память (тип, объем), МБ | GDDR5X, 12288 | GDDR5X, 11264 | GDDR5X, 12288 | GDDR5X, 8192 |

| Шина памяти, бит | 384 | 352 | 384 | 256 |

| Эффективная тактовая частота памяти, МГц | 11 408 | 11 008 | 10 008 | 10 008 |

| Пропускная способность памяти, ГБ/c | 548 | 484 | 480 | 320 |

| Тепловой пакет (TDP), Вт | 250 | 250 | 250 | 180 |

Не было сомнений в том, что NVIDIA готовит нечто новое и для почитателей ультимативных решений, которые не смотрят на ценники. И действительно, пока GeForce GTX 1080 Ti добиралась к нам на тестирование, калифорнийцы представили нового флагмана потребительской дискретной графики – GeForce TITAN Xp. Для данного адаптера используется все тот же графический процессор GP102, но уже со всеми разблокированными функциональными блоками, максимальной разрядностью шины памяти и рабочей частоты GDDR5X. Пользователи, готовые потратить на покупку видеокарты более $1200 получили новый объект для своих вожделений. Мы же пока предлагаем поближе познакомиться с возможностями более доступной новинки – GeForce GTX 1080 Ti.

Тестирование в играх

После экстремальных игровых тестирований стало очевидно, что за свою цену GTX 580 выдает оптимальный FPS в играх-современниках. Проекты ААА+ класса, вплоть до 2013 года, работают без каких-либо просадок по кадрам в секунду, что свидетельствует о высоком потенциале платы.

Такие культовые синглы, как S.T.A.L.K.E.R: Call of Pripyat, Mafia II, Metro 2033, Just Cause 2 и Sid Meier’s Civilization V идут на высоких настройках в 40-50 FPS.

Большинство современных MOBA- (Dota 2, League of Legends, Heroes of the Storm), шутеров (Counte-Strike: Global Offensive, Battlefield 3) и MMO-игр (World of Warcraft, Lineage 2) на ультра-настройках работают в 70+ кадров.

В работе

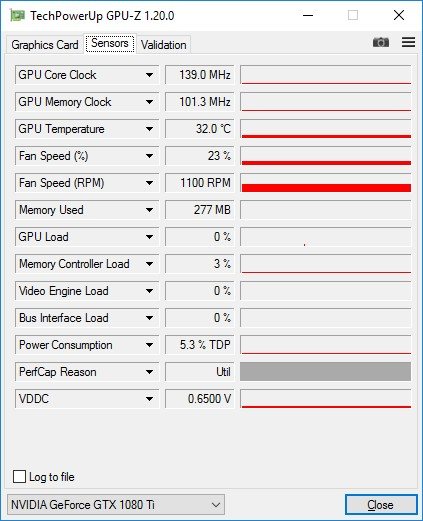

В режиме покоя на открытом стенде температура GPU удерживалась на уровне 32 градусов. При этом вентилятор вращался со скоростью порядка 1100 об/мин.

Активная система охлаждения не имеет гибридного режима работы, то есть вентилятор СО не останавливается ни при каких условиях. Впрочем, при минимальной нагрузке он очень тих.

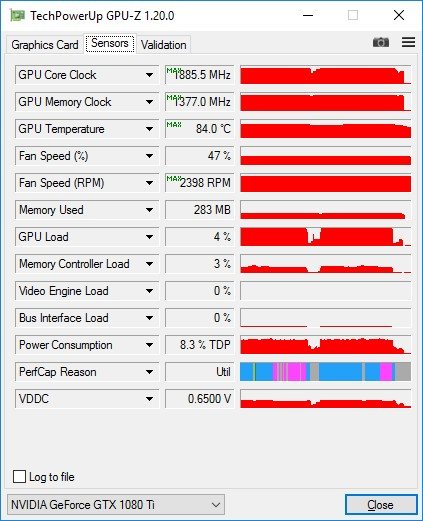

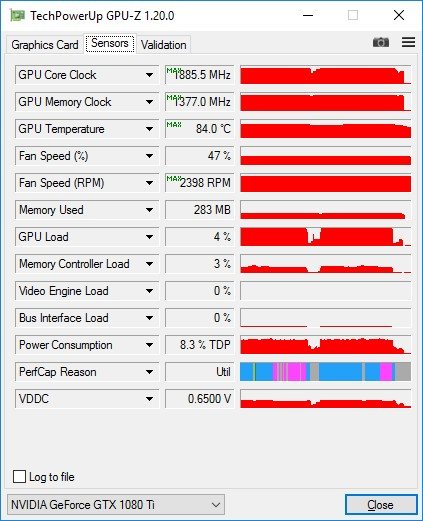

Под нагрузкой температура графического процессора повышалась до 84 градусов, при этом скорость вращения вентилятора увеличивалась до 2400 об/мин. Предположим, что в закрытом корпусе частота вращения будет еще выше. Референсные модели адаптеров NVIDIA никогда не были образцовыми устройствами для ценителей бесшумных видеокарт. На пике уровень шума GTX 1080 Ti можно охарактеризовать как средний. При этом под нагрузкой в режимах с выключенной вертикальной синхронизацией при большом количестве кадров/c в нашем случае можно было расслышать легкий шелест дроссельных катушек.

В случае с референсной GeForce GTX 1080 Ti рабочая частота графического процессора – величина очень непостоянная. Механизм GPU Boost 3.0 активно изменяет этот параметр в широких пределах, реагируя на температуру чипа и его энергопотребление. В некоторых играх GPU автоматически ускоряется до 1800–1850 МГц, в других ситуациях под нагрузкой частота может опускаться до 1700 МГц или на пике возрастать вплоть до 1886 МГц.